به گزارش سلام نو آنطور که پیوست نوشته است سهامداران، در حالی که مشتاق بهرهگیری از قدرت این فناوری نوین برای ارتقای محصولات، راندمان و جایگاه رقابتی خود هستند، با سوالاتی در حوزه اخلاق، سوگیری، حریم خصوصی داده و از بین رفتن شغلها روبرو هستند. مقررات جدیدی نیز در حال شکلگیری است که بر پیچیدگی این موضوع میافزاید.

رویکرد جامع، کلید عبور از چالشها

سازمانها تنها در صورت اتخاذ رویکردی جامع نسبت به هوش مصنوعی مسئولانه، میتوانند با این چالشها مقابله کنند. این رویکرد باید شامل اقداماتی مانند تعیین نقشها و مسئولیتهای مناسب و همچنین تمهیدات فناورانه برای آزمایش و نظارت بر مدلها باشد.

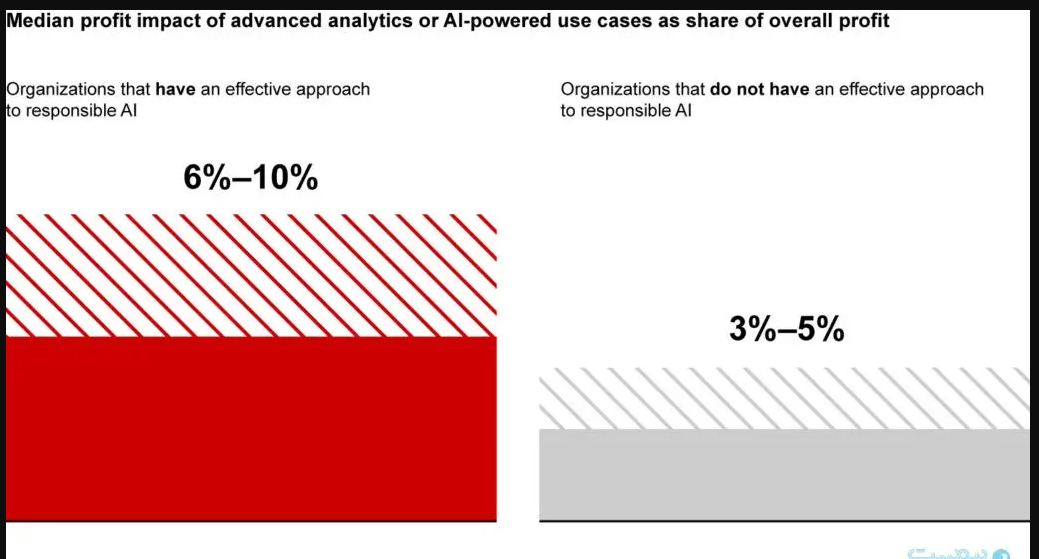

مزیت دو برابری هوش مصنوعی مسئولانه

شرکت مشاوره Bain & Company میگوید طبق تجربه، شرکتهایی که رویکردی مسئولانه به هوش مصنوعی دارند، تا دو برابر بیشتر از سایرین از این فناوری نفع میبرند. رهبران این شرکتها، به جای ترس از خطرات احتمالی، برنامههای بلندمدت و اجرایی خود را بر مبنای آزمون و خطا بنا میکنند. آنها به سرعت موارد کاربردی هوش مصنوعی را به کار میگیرند و با استفاده از اپلیکیشنهای پیچیده، ارزشآفرینی هوش مصنوعی را تسریع و تقویت میکنند. در عین حال، آنها حوزههایی که فعلاً دنبال کردن آنها به صلاح نیست (حداقل تا زمانی که فناوری پیشرفت کند یا سازمان به اندازه کافی برای مدیریت آن کاربردها بالغ شود) را نیز مشخص میکنند.

تجربه صنعت مالی و فناوری راهگشاست

تمام شرکتها میتوانند رویکردی مسئولانه در قبال هوش مصنوعی اتخاذ کنند. اگرچه فناوریهای هوش مصنوعی مولد پدیدهای جدید هستند، اما یادگیری ماشینی و هوش مصنوعی سابقهای طولانیتر دارند. صنعت خدمات مالی، از اولین صنایعی بود که رسماً راهکار مدیریت ریسک مدل را در اداره کنترل ارز ایالات متحده (OCC) به ثبت رساند. این سیاستها، توسعه مدلهای قوی، مستند و معتبر و همچنین اجرای صحیح فرایندهای نظارت و مقابله با چالشها را ترویج کرد. در دهه ۲۰۱۰ نیز، پیشتازان فناوری مانند گوگل، راهکارهایی برای آزمایش و اجرای یادگیری ماشینی توسعه دادند که به درک کاملتری از نحوه تضمین امنیت، دقت و ثبات سیستمهای یادگیری ماشینی انجامید.

هوش مصنوعی مولد، خطرات جدیدی به همراه دارد

هوش مصنوعی مولد علاوه بر خطرات شناختهشدهای مانند سوگیری، توصیفپذیری و استفاده نادرست، خطراتی مانند توهم، منشا دادههای آموزشی و مالکیت خروجی را نیز به همراه دارد.

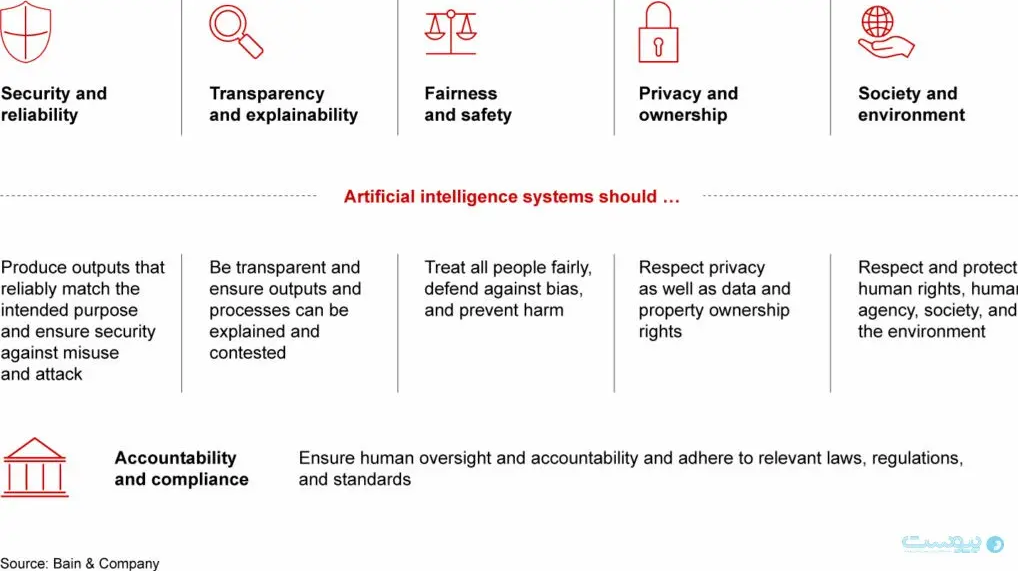

تعهد به شش اصل کلیدی

با توجه به تجارب صنعت مالی و فناوری، سازمانها باید برای مدیریت خطرات هوش مصنوعی به شش موضوع متعهد شوند:

۱. زمینهسازی برای هوش مصنوعی مسئولانه

- اهداف و تعهدات: شرکتها باید برنامه مدیریت خطر این فناوریهای جدید را به روشنی توصیف کنند و چالشهای جدید، اعم از فناورانه و اجتماعی، را به رسمیت بشناسند.

- فرایندهای حاکمیتی، نقشها و فناوری: رویکردهای موجود باید با توجه به فناوری و فعالیتهای جدید در چرخه حیات راهحلهای هوش مصنوعی تکمیل شوند.

- فرهنگ: آموزش و تعامل سازمانی باید با توجه به گسترش استفاده از هوش مصنوعی مولد، به طور مداوم انجام شود.

۲. تشریح گامهای بعدی

در ادامه، هر یک از این بخشها با جزئیات بیشتری بررسی خواهند شد.

انتظارات ذینفعان از هوش مصنوعی

مشتریان، کارکنان، سهامداران، سرمایهگذاران، رگولاتورها و جوامع، خواستار اکتشاف و استفاده مسئولانه از هوش مصنوعی در سازمانها هستند. آنها انتظار دارند تا شرکتها بر تضمین امنیت، دقت و عدم سوگیری سیستمهای هوش مصنوعی خود تمرکز کنند و این سیستمها به شکلی اخلاقی به کار گرفته شوند. علاوه بر این، مقررات و پیشنیازهای آینده نیز باید در طراحی این سیستمها مد نظر قرار گیرد.

تعادل بین تعهدات و ریسکپذیری

هر سازمانی باید تعهدات خود در قبال هوش مصنوعی را با توانمندیها، میزان تاثیر احتمالی و پیشنیازهای خاص بازار و مکان خود منطبق کند. استراتژی و میزان ریسکپذیری یک شرکت، تعیینکنندهی نوع کاربردهای هوش مصنوعی است که توسعه میدهد. به تبع آن، نوع سرمایهگذاریهای مورد نیاز و سطح ارزشآفرینی نیز مشخص میشود. برای مثال، برخی از سازمانها در صنایعی که تحت نظارت شدید قانون فعالیت میکنند، تا زمانی که درک بهتری از هوش مصنوعی مولد پیدا نکنند، نمیتوانند این اپلیکیشنها را در اختیار مشتریان خود قرار دهند.

ساختار کارآمد حاکمیتی برای هوش مصنوعی

پس از تعیین تعهدات، شرکتها میتوانند به بررسی فرصتهای استفاده از محصولات و راهحلهای هوش مصنوعی بپردازند. در این مسیر، به ساختارها، سیاستها و فناوری مناسب نیاز است.

مسئولیتها و ساختارهای سازمانی

هوش مصنوعی مولد بر تمام واحدهای تجاری و عملیاتهای شرکتی تاثیر میگذارد. به دلیل ماهیت فراگیر این فناوری، حاکمیتی با ساختار میانوظیفهای که افراد کلیدی تمامی گروههای مرتبط را شامل شود، ضروری است. همه باید از نقشها و مسئولیتهای خود به طور شفاف آگاه باشند. رهبران تجاری باید مسئولیت ادغام هوش مصنوعی مسئولانه در پیشنهادات و عملیاتها را برعهده بگیرند.

ایجاد ذهنیت مسئولیتپذیری

با این اقدامات، ذهنیت مسئولیتپذیری در سازمان شکل میگیرد. برخی از شرکتها ممکن است برای شفافیت بیشتر، یک رهبر اصلی را به طور ویژه به هوش مصنوعی مسئولیتپذیر اختصاص دهند.

نمونههایی از ساختارهای حاکمیتی

حدود یک چهارم از لیست ۲۰ شرکت برتر مجله فورچن (Fortune ۲۰) در حال حاضر چنین جایگاهی را در نظر گرفتهاند. برای مثال، شرکت مایکروسافت یک رئیس ارشد هوش مصنوعی مسئولانه را در اداره هوش مصنوعی مسئولانه خود جای داده است. این مدیر وظیفه تعریف رویکرد شرکت نسبت به هوش مصنوعی مسئولانه و تقویت کارکنان برای استفاده درست از آن را برعهده دارد.

بازنگری و بهروزرسانی سازوکارهای حاکمیتی

بیشتر سازمانها باید سازوکارهای حاکمیتی موجود از جمله سازوکارهای فناوری، داده، فروشندگان و امنیت اطلاعات را بازنگری و هرگونه تغییر ضروری را برای رفع خطرات جدید حاصل از هوش مصنوعی و آنهایی که در نتیجه این فناوری تشدید میشوند، شناسایی کنند.

ایجاد آییننامه رفتاری

ساخت یا بروزرسانی یک آییننامه رفتاری واضح برای بسیاری از شرکتها ارزشمند است. این کار را میتوان به واسطه آیین گسترده شهروندی دیجیتال یا مسئولیتپذیری داده، یا از طریق آییننامههایی که به طور خاص برای اخلاق هوش مصنوعی طراحی شدهاند، به انجام رساند.

استانداردهای هوش مصنوعی مسئولانه

استاندارد هوش مصنوعی مسئولانه مایکروسافت پیشنیازهایی را تعریف کرده و دستورالعملی، ابزارها و فعالیتهایی مشخص و قابل اجرا را در اختیار کارکنان قرار میدهد تا از آن در کار روزمره خود برای اعمال اصول هوش مصنوعی مسئولانه استفاده کنند.

فرهنگ مسئولیتپذیری در هوش مصنوعی

موفقیت هوش مصنوعی به مسئولیتپذیری در فرهنگ سازمان بستگی دارد. شرکتهایی که حاکمیت مناسب و عملکرد خوبی دارند تضمین میکنند که:

مسئولیت هماهنگی میانوظیفهای در سیاستها، فرایندها و حاکمیت هوش مصنوعی مسئولانه، برعهده مدیران است. اعضای تیم منابع و مهارتهای لازم برای استفاده موثر و مسئولانه از هوش مصنوعی را در اختیار دارند. سازمان تعهدات مسئولانه خود را اعلام کرده و برآنها نظارت و تاکید میکند و گفتمانی فعال با گروهها دارد تا تعادل بین خطر و فواید برقرار شود.

نظر شما